Os atuais data centers de IA enfrentam dois gargalos principais no dimensionamento, e os modelos tradicionais de-aumento e expansão{1}}estão lutando para atender às demandas de IA em{2}}giga escala:

Limitações de{0}aumento de escala: alcançado por meio da atualização de sistemas ou racks únicos (por exemplo, aumentando a contagem de GPUs ou melhorando o desempenho-de dispositivos únicos), mas limitado por limites de energia de infraestrutura como refrigeração líquida. Os data centers existentes têm limites físicos para entrada de energia e dissipação de calor, evitando aumentos infinitos na densidade de computação por rack ou data center.

Limitações de expansão-escalável: Expandido pela adição de racks e servidores para dimensionar clusters, mas limitado pelo espaço físico em um único local, impondo limites rígidos à capacidade do equipamento.

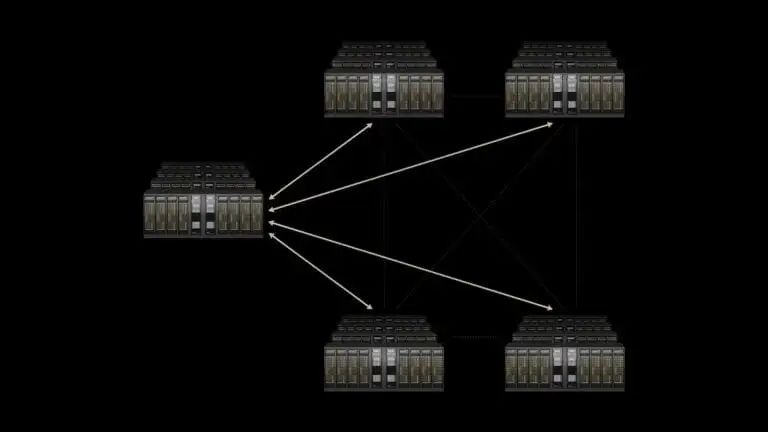

Para superar esse dilema, a NVIDIA propõe a nova dimensão de "escala-transversal", otimizando a comunicação de rede entre data centers geograficamente dispersos para fazer com que clusters de IA distribuídos colaborem como um só. O fundador e CEO da NVIDIA, Jensen Huang, descreve essa superfábrica de IA inter{2}}regional como uma infraestrutura essencial para a revolução industrial de IA, com o Spectrum-XGS como o principal facilitador da tecnologia.

Principais tecnologias do Spectrum-XGS

Spectrum-XGS não é uma plataforma de hardware totalmente nova, mas uma evolução do ecossistema Spectrum-X Ethernet existente da NVIDIA. Desde seu lançamento em 2024, o Spectrum{4}}X oferece desempenho de rede de IA generativa 1,6x maior do que a Ethernet tradicional por meio dos switches SN5600 da arquitetura Spectrum{10}}4 e DPUs BlueField-3, tornando-se a escolha principal para data centers de IA que usam GPUs NVIDIA. A inovação no Spectrum-XGS reside em três inovações algorítmicas e sinergias de hardware que abordam latência de comunicação, congestionamento e desafios de sincronização em clusters de GPU inter-regionais.

1. Algoritmos principais: adaptação dinâmica às características de redes-de longa distância

O núcleo do Spectrum-XGS é um conjunto de "algoritmos de otimização de rede-com reconhecimento de distância" que analisam os principais parâmetros da comunicação entre-data{3}}centers em tempo real-(distância, padrões de tráfego, níveis de congestionamento, métricas de desempenho) e ajustam dinamicamente as políticas de rede:

Distância-controle de congestionamento adaptativo:Ao contrário do tratamento uniforme de todas as conexões da Ethernet tradicional, os algoritmos Spectrum{0}}XGS ajustam automaticamente os limites de congestionamento com base nas distâncias reais entre data centers (atualmente suportando implantações de até centenas de quilômetros), evitando perda ou acúmulo de pacotes em transmissões de longa-distância.

Gerenciamento preciso de latência:Por meio do roteamento adaptativo-de granularidade fina-por pacote, ele elimina a instabilidade de latência das retransmissões de pacotes em redes tradicionais. O jitter é um risco crítico em clusters de IA: se uma única GPU atrasar devido ao atraso, todas as GPUs colaboradoras deverão esperar, impactando diretamente o desempenho geral.

Telemetria-a{1}}de ponta a ponta: a coleta-em tempo real de dados completos de-desempenho de link de GPUs para switches e links de-data{3}}cruzados fornece feedback em nível de milissegundo-para ajustes algorítmicos, garantindo a correspondência dinâmica do status da rede com as demandas de carga de trabalho de IA.

2. Sinergias de hardware: aproveitando a base de alta largura de banda do-ecossistema X do Spectrum

Spectrum{0}}XGS alcança desempenho ideal quando combinado com hardware NVIDIA específico:

Espectro-Comutadores X: como backbone de rede subjacente, fornecendo alta densidade de porta e encaminhamento de baixa{0}latência.

SuperNIC ConnectX-8: Adaptador de rede dedicado-de IA de 800 Gb/s para transferência de dados em alta-velocidade entre GPUs e switches.

Hardware de arquitetura Blackwell: como GPUs B200 e superchips GB10, profundamente integrados ao Spectrum-XGS para reduzir a latência-a{4}}de ponta a ponta. NVIDIA validada por meio de benchmarks da NCCL (biblioteca de comunicações coletivas): Spectrum-XGS aumenta o desempenho da comunicação entre GPUs de-data{8}}entre centros de dados em 1,9x enquanto controla a latência-a{11}}de ponta a ponta em cerca de 200 milissegundos-um nível que parece responsivo e sem atrasos-para as interações do usuário, atendendo aos-requisitos em tempo real para inferência de IA.

Otimização-completa da pilha para treinamento de IA e eficiência de inferência com Spectrum-XGS

Spectrum-XGS não é uma tecnologia isolada, mas uma adição importante ao ecossistema de IA full-stack da NVIDIA. Nesta versão, a NVIDIA também revelou melhorias de desempenho-no nível de software que sinergizam com o Spectrum-XGS para colaboração de software-algoritmo-de hardware:

Atualização de software do Dynamo: Otimizado para arquitetura Blackwell (por exemplo, sistemas B200) para aumentar o desempenho de inferência de modelos de IA em até 4x, reduzindo significativamente o consumo de computação para inferência de modelos grandes.

Tecnologia de decodificação especulativa: usa um pequeno rascunho do modelo para prever antecipadamente o próximo token de saída do modelo principal de IA, reduzindo a computação do modelo principal e melhorando o desempenho da inferência em mais 35%. Isto é especialmente adequado para cenários de inferência conversacional em grandes modelos de linguagem (LLMs).

O diretor do departamento de computação acelerada da NVIDIA, Dave Salvator, afirmou que o objetivo principal dessas otimizações é escalar aplicações ambiciosas de IA de agência. Seja treinando modelos grandes de-trilhões de parâmetros ou oferecendo suporte a serviços de inferência de IA para milhões de usuários simultâneos, a combinação do Spectrum-XGS e do ecossistema de software oferece desempenho previsível.

Aplicações iniciais e impacto do Spectrum{0}}XGS na indústria

Primeiros usuários: CoreWeave Pioneers Cross{0}}Domain AI Super FactoryO provedor de serviços de nuvem GPU CoreWeave está entre os primeiros a adotar o Spectrum-XGS. O co-fundador e CTO da empresa, Peter Salanki, observou que essa tecnologia permitirá que seus clientes acessem recursos de IA em escala-gigante, acelerando avanços em todos os setores. Por exemplo, apoiar projetos de IA em escala ultra-grande-, como a iniciativa Stargate da Oracle, SoftBank e OpenAI.

Tendências do setor: Ethernet substituindo InfiniBand como principal rede de IAEmbora a InfiniBand detivesse cerca de 80% do mercado de redes backend de IA em 2023, a indústria está mudando rapidamente para Ethernet. A escolha da NVIDIA de desenvolver Spectrum{3}}XGS em Ethernet está alinhada com esta tendência:

Compatibilidade e vantagens de custo:Ethernet é o padrão universal para data centers globais, mais familiar aos engenheiros de rede e mais barato de implantar do que o InfiniBand.

Projeções de escala de mercado:Dados do Grupo Dell'Oro mostram que o mercado de switches Ethernet para data centers atingirá quase US$ 80 bilhões nos próximos cinco anos.

O próprio crescimento da NVIDIA: Os relatórios do 650 Group indicam a NVIDIA como o "fornecedor de crescimento-mais rápido" no mercado de switches de data center de 2024, com sua receita de negócios de rede atingindo US$ 5 bilhões no trimestre2 2024 (terminando em 27 de abril), um aumento de 56% ano-após-ano.

O lançamento do Spectrum-XGS amplia a estratégia de monopólio-full stack da NVIDIA em infraestrutura de IA, ao mesmo tempo que estimula novas dinâmicas competitivas:

Layout de pilha-completa da NVIDIA: De GPUs (Blackwell), interconexões (NVLink/NVLink Switch), redes (Spectrum-X/Spectrum-XGS, Quantum-X InfiniBand) até software (CUDA, TensorRT-LLM, microsserviços NIM), a NVIDIA formou uma rede fechada loop que cobre "software de computação-conexão-" para infraestrutura de IA. Spectrum-XGS sinergiza com NVLink para escalonamento em três-níveis: intra-rack (NVLink), intra-data-center (Spectrum-X) e cross-data-center (Espectro-XGS).

Respostas dos concorrentes: a tecnologia SUE anterior da Broadcom compartilha objetivos semelhantes com o Spectrum-XGS, com o objetivo de otimizar o desempenho da Ethernet para preencher a lacuna com o InfiniBand. Além disso, fornecedores como Arista, Cisco e Marvell estão acelerando switches Ethernet dedicados-de IA, com a concorrência focada na compatibilidade do ecossistema-custo{4}}de desempenho.

O principal valor do Spectrum-XGS reside em impulsionar o escalonamento do data center de IA de "restrições-de local único" para "colaboração-interregional". À medida que a energia e o terreno se tornam limites rígidos para data centers únicos, superfábricas de IA entre-cidades e{5}}países se tornarão a forma principal de suporte a aplicativos de IA da próxima-geração (por exemplo, inteligência artificial geral, clusters de agentes em-grande escala).

Como o vice-presidente sênior do departamento de redes da NVIDIA, Gilad Shainer, previu na conferência Hot Chips: "Redes físicas de fibra óptica de-data{1}}centers cruzados existem há muito tempo, mas algoritmos de software como Spectrum-XGS são a chave para desbloquear o verdadeiro desempenho dessas infraestruturas físicas."